Использование наукометрических показателей для оценки научной деятельности

Аннотация: В статье рассматриваются проблемы, связанные со

способами оценки эффективности научной деятельности в России,

основными целями этой оценки и методами ее осуществления. Особое

внимание уделяется наукометрическим методам оценки публикационной

эффективности научной деятельности в вузе при их рейтинговании и при

оценке заявок на выполнение НИР и отчетов о деятельности вузов или

отчетов о реализации конкретных научных проектов. Оценивается

возможность использования современных наукометрических инструментов

для планирования научной деятельности и ее оценки. Описываются

проблемы корректного использования данных о количестве публикаций и их

цитировании. Приводится сравнительное описание инструментов

визуализации наукометрических показателей организации, разработанных

компаниями «Elsevier» и «Thomson Reuters».

Abstract: The article is devoted to the description of research assessment in

Russia, the main goals and methods of such assessment. The special attention is

paid for the scientometric methods in evaluation of publication effectiveness of

research in higher educational institutions during their ranking and in different

grant proposals and reports. The possibility of using the modern analytical

instruments, created by leading companies such «Thomson Reuters» and

«Elsevier», in research planning and assessment is analyzed. The problems of

correct interpretation of data on the number of publications and their citation are

described. We present a comparative description of the visualization tools

scientometric indicators of the organization, developed by companies «Elsevier»

and «Thompson Reuters».

В последнее время все большее значение при выделении финансовых и

материально-технических ресурсов уделяется вопросам повышения

эффективности научной деятельности, разрабатываются критерии оценки и

показатели, демонстрирующие, как работают отдельные ученые, группы

ученых, институты и вузы. В связи с этим постоянно используются понятия

«индекс цитирования», «индекс Хирша» и другие параметры. Причем далеко

не все ученые и администраторы знают и понимают, что означают, откуда

берутся и как рассчитываются эти индексы. Еще менее понятно, можно ли

использовать эти показатели для сравнения деятельности разных ученых,

лабораторий или институтов, и если можно, то как? Индекс Хирша – 10 – это

хороший показатель или плохой? Теоретические знания можно при желании

получить из имеющейся литературы по наукометрии, где есть

соответствующие определения, но что делать, когда в отчетных документах

просят указать количество статей и их цитирований по «Web of science», и не

указывают, где и как эти данные получить?

Рассмотрим, в каких документах, заполняемых учеными при подаче

заявок на финансирование, или в каких отчетах фигурируют сведения о

публикационной активности.

Заявки на финансирование в рамках федеральных целевых программ:

1. ФЦП «Исследования и разработки по приоритетным направлениям

развития научно-технологического комплекса России» предполагает

сведения о квалификации участника конкурса, включающие данные о

наличии публикаций по результатам работ в предметной области лота и

индекс цитирования (в соответствии с данными «Web of science», «Scopus» и

др.).

2. ФЦП «Научные и научно-педагогические кадры инновационной

России». Для осуществления мероприятия 1.1 «Проведение исследований

научно-образовательными центрами» требуется: список десяти наиболее

значимых публикаций членов коллектива НОЦ в области тематики конкурса

за последние 3 года с указанием импакт-фактора журналов. Для журналов

без импакт-фактора следует указывать 0. Необходимо перечислить

организации, указанные в статье, как место работы авторского коллектива.

Кроме того, необходимо при описании квалификации коллектива

исполнителей указать количество публикаций и индекс цитирования строго в

соответствии с данными Научной электронной библиотеки «Elibrary.ru». В

заявках по данному мероприятию использование иных индексов

цитирования, кроме РИНЦ, предусмотрено не было.

Для мероприятия 1.2.1–1.2.2 «Проведение научных исследований по

руководством докторов/кандидатов наук» в разделе «Профессиональная

репутация и квалификация коллектива исполнителей» приводятся данные о

количестве публикаций в научной периодике, индексируемой

международными («Web of science», «Scopus», «Web of knowledge»,

«Astrophysics», «PubMed», «Mathematics», «Chemical abstracts», «Springer»,

«Agris») и российской индекс научного цитирования (РИНЦ) системами

цитирования и индексе цитирования в соответствии с теми же системами

цитирования [2].

Вероятнее всего, набор международных систем цитирования

позаимствован составителями конкурсной документации из Перечня

4

ведущих рецензируемых научных журналов и изданий, в которых должны

быть опубликованы основные научные результаты диссертаций на соискание

учёной степени доктора и кандидата наук. Как следует из информации,

размещенной на официальном сайте Высшей аттестационной комиссии 1

,

перечень сформирован на основе утвержденных критериев, которым должны

удовлетворять издания, претендующие на включение в Перечень. Научные

периодические издания, текущие номера которых или их переводные версии

на иностранном языке включены хотя бы в одну из систем цитирования

(библиографических баз) «Web of science», «Scopus», «Web of knowledge»,

«Astrophysics», «PubMed», «Mathematics», «Chemical abstracts», «Springer»,

«Agris», «GeoRef», являются включенными в Перечень.

Неясным остается, почему из перечня баз данных в конкурсной

документации по ФЦП «Кадры» убрали «GeoRef» и по каким признакам

издательство «Springer» можно отнести к системе цитирования. Удивительно

также перечисление через запятую «Web of science» и «Web of knowledge»,

тогда как «Web of science» является лишь составной частью платформы

«Web of knowledge», включающей в себя, кроме «Web of science», базы

данных «Medline» и «Journal citation report» (JCR), а также дополнительные

ресурсы – «Essential science indicators», «Scientific WebPlus», «Biology

browser» и др.

Заявки на гранты Правительства Российской Федерации для

государственной поддержки научных исследований, проводимых под

руководством ведущих ученых в российских образовательных учреждениях

высшего профессионального образования содержат уже совсем

нестандартные показатели, для которых приводятся способы их расчета.

Кроме уже привычного количества статей в системах цитирования «Web of

science», «Scopus», «Web of knowledge», «Astrophysics», «PubMed»,

«Mathematics», «Chemical abstracts», «Springer», «Agri» и РИНЦ, в заявке

предлагается указать индекс Хирша ведущего ученого на момент подачи

1 Режим доступа: http://vak.ed.gov.ru/ru/help_desk/list/

5

заявки, рассчитанный по базе «Web of science», индекс цитирования 10-ти

наиболее значимых публикаций, с точки зрения самого ученого.

Появляются новые показатели: Совокупный импакт-фактор статей

ведущего ученого за 2006–2010 гг. (оценка по 2009 «JCR science edition»), и

cовокупный импакт-фактор статей работников вуза по заявленному

направлению научного исследования за три года (оценка по 2009 «JCR

science edition»), отнесенный к количеству научно-педагогических

работников вуза в отчетном году. Необходимо посчитать суммарный импакт-

фактор журналов, в которых опубликованы статьи за период, указанный в

показателе (в расчете импакт-фактор журнала участвует столько раз, сколько

в нем статей опубликовано). Для расчета импакт-фактора статей по таким

областям наук, как психология, когнитивные исследования, экономика,

международные исследования и социология можно использовать не 2009

«JCR science edition», а 2009 «JCR social sciences edition». При этом в форме

необходимо указать, по какой базе проводился расчет [3].

Неясным остается только одно – что эти новые показатели могут

показать и о чем по ним можно судить? Если первый из введенных

показателей еще может служить какой-то характеристикой публикационной

активности ученого за последние несколько лет, и то только при сравнении

нескольких ученых в одной научной области, то второй показатель, где

проводится нормирование на общее количество научно-педагогических

работников вуза данных о публикациях в конкретной области, вообще уже

непонятно о чем говорит. Единственное, для чего его можно использовать,

так это для сравнения данных по последовательно взятым временным

периодам и прослеживания динамики публикационной активности одного и

того же коллектива.

В соответствии с Концепцией создания и государственной поддержки

развития федеральных университетов Министерством образования и науки

разработаны основные показатели эффективности федеральных

университетов, в которых в качестве показателя результативности

6

исследовательских работ используются данные о количестве публикаций в

зарубежных изданиях, индексируемых иностранными организациями [7].

При этом нигде не указывается, что подразумевается под иностранными

организациями, индексирующими зарубежные издания, неясно, учитываются

ли при этом переводные версии российских журналов, индексируемые этими

иностранными организациями. Имеются ли здесь в виду, например,

«Thomson Reuters» («Web of science») и «Elsevier» («Scopus»)?

Показатели оценки эффективности реализации программ развития

национальных исследовательских университетов (НИУ) в части

результативности научно-инновационной деятельности также содержат

аналогичные, правда, чуть более конкретизированные формулировки:

«Количество статей по приоритетным направлениям развития НИУ в

научной периодике, индексируемой иностранными и российскими

организациями (Web of Science, Scopus, Российский индекс научного

цитирования), в расчете на одного научно-педагогического работника». При

этом также не предлагается приводить данные по каждой из упомянутых баз

отдельно, несмотря на значительное пересечение имеющейся в них

информации.

В Приложении к приказу Рособразования от 28 ноября 2008 г. № 1770

[8] «Целевые показатели эффективности работы государственных

образовательных учреждений высшего профессионального образования,

подведомственных Рособразованию» в качестве показателей

результативности научной и научно-технической деятельности вуза

указываются данные о количестве научных публикаций в рецензируемых

изданиях на одного научно-педагогического работника вуза в зарубежных и

российских изданиях (раздельно). Указаний на конкретные

наукометрические базы данных или системы цитирования не приводится.

Аналогичные данные предусмотрены в разделе «результативность» отчета о

научно-исследовательской деятельности вуза, ежегодно представляемого

Минобрнауке подведомственными высшими учебными заведениями.

7

Оценка результативности деятельности научных организаций,

осуществляемая в соответствии с типовой методикой оценки

результативности деятельности научных организаций, выполняющих

научно-исследовательские, опытно-конструкторские и технологические

работы гражданского назначения, утвержденной приказом Министерства

образования и науки Российской Федерации от 14 октября 2009 г. № 406,

также предусматривает предоставление наукометрических данных:

– Число публикаций работников научной организации в РИНЦ,

отнесенное к численности исследователей (за каждый год из последних пяти

лет, начиная с года, предшествующего текущему). Цитируемость работников

научной организации в РИНЦ (общее число ссылок на публикации

работников научной организации в РИНЦ за каждый год из последних пяти

лет, начиная с года, предшествующего текущему, отнесенное к численности

исследователей научной организации в году, предшествующем текущему)

– Число публикаций работников научной организации в «Web of

science», отнесенное к численности исследователей (число публикаций за

последние пять лет, начиная с года, предшествующего текущему,

численность исследователей в году, предшествующем текущему).

– Цитируемость работников научной организации в «Web of science»

(общее число ссылок на публикации работников научной организации в Web

of science за последние пять лет, начиная с года предшествующего текущему,

отнесенное к численности исследователей научной организации в году,

предшествующем текущему)

– Импакт-фактор публикаций работников научной организации в «Web

of science» (число публикаций работника научной организации в журнале,

зарегистрированном в «Web of science» за каждый год из последних пяти лет,

начиная с года, предшествующего текущему, умножается на импакт-фактор

данного журнала в соответствующем году; сумма полученных значений по

годам, работникам и журналам делится на общее за последние пять лет число

публикаций работников научной организации в «Web of science»).

8

Академия наук Постановлением Президиума РАН от 21.10.10 №201

утвердила несколько видоизмененную Методику оценки результативности

деятельности научных организаций Российской академии наук.

Кардинальных отличий от утвержденной Правительством методики не

наблюдается, кроме расширенного списка баз данных, присутствие в

которых учитывается при подсчете публикаций:

– Число публикаций работников научной организации отнесённое к

численности исследователей, в том числе в зарубежных научно-технических

изданиях, в отечественных изданиях, включённых в перечень ВАК

Минобрнауки России.

– Число публикаций работников научной организации в РИНЦ,

отнесенное к численности исследователей. Цитируемость работников

научной организации в РИНЦ, отнесенное к численности исследователей.

– Число публикаций работников научной организации в базах

реферативной информации («Web of science», «Scopus», «Medline»,

«Metadex», «Compendex», «Pascal», «Biosis» и др.), отнесенное к численности

исследователей.

– Цитируемость работников научной организации в указанных базах

реферативной информации. Импакт-фактор публикаций работников научной

организации в «Web of science».

В рейтингах вузов также применяются показатели, характеризующие

публикационную активность:

1. Международные рейтинги «Times higher education» [1, 12] и «Academic

ranking of world universities» (ARWU) [9] используют данные о публикациях

и их цитировании, представленные в «Web of science», как один из

показателей, характеризующих научную деятельность вуза. В ARWU в

качестве дополнительного показателя используются данные еще одной базы,

входящей в состав «Web of knowledge» – HighlyCited.com. Из этой базы

берутся данные о количестве ученых, попадающих в перечень наиболее

цитируемых авторов.

9

2. В рейтинге QS (Quacquarelli Symonds) [14] используются аналогичные

данные из базы данных Scopus – количество статей вуза и их цитирований за

5 лет.

3. Российские рейтинги используют, кроме «Web of science» и Scopus,

данные РИНЦ.

– Рейтинг научной и публикационной активности Высшей школы

экономики в 2010 опирался на данные РИНЦ.

– Рейтинг российских вузов по научным достижениям Рейтор в 2009 г.

опирался на базу данных Scopus.

– Национальный рейтинг российских вузов, проведенный совместно

Интерфакс и Эхо Москвы (вероятный наследник Рейтор) в 2009 и 2010 г.

полагался на данные из «Web of science», «Scopus» и РИНЦ.

Общим недостатком российских рейтингов при учете публикационной

активности является нечеткость используемых параметров. Как правило,

нигде не оговариваются сроки или временные промежутки получения

данных. А между тем базы данных являются постоянно обновляемыми и

информация, полученная с перерывом в несколько дней, может сильно

различаться. Правила нормирования данных о публикациях остаются

неопределенными, указания на источники информации о численности

сотрудников и описание категории сотрудников, подлежащих обследованию

(только ППС, научно-педагогические работники, научные сотрудники,

работающие на постоянной основе, или включая совместителей, учитывается

количество сотрудников или число полных ставок, т.е. среднесписочная

численность), – нечеткими. Все это создает достаточную неопределенность в

трактовке данных рейтингов.

Даже если исправить все вышеуказанные недостатки методик оценки

эффективности или составления рейтингов, остается одна самая важная на

сегодняшний день проблема – проблема получения достоверных данных о

публикациях организации. Самые крупные и авторитетные

наукометрические базы данных «Web of science» и «Scopus» являются

10

платными ресурсами и далеко не все научные организации или вузы могут

себе позволить недешевую подписку. Доступ к РИНЦ – бесплатный, но этот

ресурс еще достаточно молодой и накопленные базы не полностью отражают

публикационную активность российских ученых. Можно надеяться на то, что

в ближайшие пять–десять лет при активном содействии самих ученых через

открытый недавно «Science index», в РИНЦ можно будет получить

достоверные данные о деятельности отдельного ученого и организации.

Так все-таки можно ли сравнивать по количеству публикаций и их

цитированию работу разных ученых или институтов? Эти показатели так

сильно зависят как от области знаний, так и от возраста ученого или

организации, что напрямую, естественно, их применять нельзя.

Использование средних показателей, таких как цитирование одной статьи,

также неадекватно, особенно при сравнении физиков и лириков и даже

физиков-теоретиков и физиков-экспериментаторов. Для решения этой

проблемы имеется масса подходов, основанных, как правило, на

использовании разнообразных весовых и нормированных показателей.

Основные используемые в наукометрии (библиометрии) показатели

можно условно разделить на две основные группы. Показатели

«рейтинговости» журнала: Импакт-фактор (JCR, «Thomson Reuters» или

РИНЦ); Source-normalized impact per paper – SNIP; SCIMago journal ranking –

SJR. Показатели публикационной деятельности ученого, организации,

области знаний и т.д.: индекс Хирша, средняя цитируемость.

Импакт-фактор журнала – широко используемый показатель,

разработанный еще в 60-х годах XX в. Институтом научной информации

(ISI) и представляемый ежегодно в дополнительном ресурсе «Thomson

Reuters» «Journal citation report». Показатель рассчитывается, как количество

ссылок в конкретном году на опубликованные в журнале статьи за

предшествующие 3 года, и является в какой-то мере характеристикой

авторитетности журнала. Этот показатель хорош для сравнения журналов,

близких по тематике, однако не дает возможности сравнивать качество

11

журналов из разных научных областей. Способ расчета импакт-фактора

приведен на рис. 1 [6].

Рис.1. Схема расчета импакт-фактора журнала

Основными недостатками импакт-фактора являются существенная

зависимость от области науки, произвольный временной отрезок

публикационного окна и различие типов документов в числителе и

знаменателе формулы расчета. В числителе учитываются ссылки из всех

типов документов, а в знаменателе учитываются только статьи (articles) и

обзоры (reviews).

Для сравнения цитируемости в разных областях знаний в «Web of

knowledge» есть специально организованный ресурс – «Essential science

indicators», где представлены статистические данные за последние 10 лет по

областям знаний, странам, организациям. Нормируя конкретные данные по

цитируемости статей отдельного ученого или организации в конкретной

области знаний на среднестатистические данные, приведенные в Essential

science indicators, можно оценить уровень ученого или организации в

12

конкретной научной области или по сравнению с мировыми данными или

данными по стране.

Для ранжирования журналов, аналогичного ранжированию по импакт-

фактору в «Web of knowledge», «Scopus» использует другие показатели,

которые уже являются нормированными и учитывают не только количество,

но и качество ссылок на конкретные статьи. «SCImago journal ranking» – SJR

[10] – разработанный университетом Гранады рейтинг журналов, в котором

учитываются не только общее количество цитирований, но и взвешенные

показатели цитирований по годам и качественные показатели, такие как

авторитетность ссылок. Вес ссылки в журнале «Nature» на статью в журнале

«А» будет отличаться от веса ссылки на ту же статью в журнале «Вестник Nского

университета», на который ссылок в Scopus совсем или почти нет. В

целом SJR не очень сильно отличается от привычного импакт-фактора,

весьма привлекая более широким спектром журналов и полностью открытым

характером, поскольку публикуется в свободном доступе в Интернете [10].

Еще более продвинутый показатель, используемый «Scopus», SNIP,

разработан в Лейденском университете проф. Х.Ф. Моэдом [13]. Этот

показатель учитывает и уровень цитирований в каждой научной области, так

что может быть использовано для сравнения публикаций в разных научных

направлениях. Основные особенности расчета этого показателя заключаются

в следующем:

1. В показателе учитываются ссылки, сделанные в текущем году на

статьи, вышедшие в течение трех предыдущих лет. Публикационное окно – 3

года, окно цитирования – 1 год, типы документов — одинаковые для всех

этапов подсчета показателя.

2. Вводится специальное определение «индивидуальной области науки»

для журнала (окружения журнала). Все статьи, опубликованные в текущем

году (в любом издании), которые хотя бы однажды цитировали выпуски

журнала, вышедшие за последние десять лет, составляют окружение

журнала.

13

3. Для определения потенциала цитирования (средняя длина списков

цитируемой литературы в статьях окружения) подсчитывается среднее число

ссылок в статьях, составляющих окружение журнала. Но учитываются

только те ссылки, которые ведут на статьи, вышедшие в течение трех

предыдущих лет или ведут на статьи, имеющиеся в базе данных, по которой

идет расчет. Окончательный расчет показателя проводится по следующей

формуле:

SNIP =

Среднее число ссылок, полученных в текущем году

статьями журнала, опубликованными за три предыдущих года

Потенциал цитирования для данного журнала

Во второй группе «нежурнальных» показателей в первую очередь

следует отметить индекс Хирша (h-index) [11]. Индекс Хирша ученого,

опубликовавшего N статей, равен h, если h его статей получили не менее h

цитирований; остальные N–h его статей получили не более h цитирований.

Среднее цитирование – общее количество ссылок на статьи ученого,

деленное на общее количество статей.

Отличительной особенностью этих показателей является то, что они

могут применяться к любому массиву статей автора, лаборатории, института,

страны и за любой период времени.

«Нежурнальные» показатели также весьма сильно зависят от множества

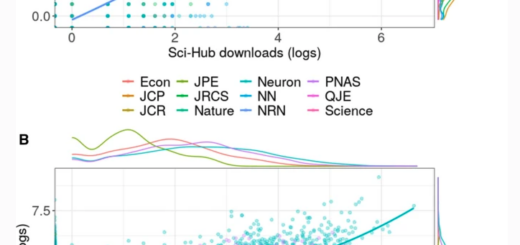

факторов. На рис.2 приведены графики зависимости индекса Хирша от таких

факторов как количество публикаций, количество цитирований, год первой

учитываемой публикации, т.е. возраста ученого, рассчитанные по данным

интернет-ресурса «Scientific.ru».

14

Рис.2. Зависимость индекса Хирша от различных факторов

(значение индекса Хирша на всех рисунках отложено по вертикальной оси)

15

По данным Essential Scientific Indicators среднее цитирование статей

варьирует в зависимости от области знаний. Для статей, опубликованных в

2001 г., среднее цитирование для всех областей составляет 20,7, в то время

как для статей по молекулярной биологии и генетике этот показатель

достигает 49,95, а для математики – 6,75, т.е. количественные показатели

цитирования статей по этим областям знаний различаются более чем в 7 раз.

Именно с целью сравнительной оценки эффективности научной

деятельности в разных областях науки крупнейшие наукометрические базы

разрабатывают специальные аналитические инструменты. В последнее время

в мире все больше и больше начинают использовать такие инструменты при

стратегическом планировании науки, при оценке работы отдельных

организаций, для принятия решений о выделении финансирования

конкретных проектов и организаций. Что же это за инструменты?

Компания «Thomson Reuters» разработала «InCites», позволяющий

анализировать публикации на основе данных «Web of science». Похожим

продуктом второй крупнейшей компании «Elsevier», являющейся создателем

базы данных «Scopus», стал аналитический инструмент «SciVal spotlight».

Если посмотреть на общие характеристики, то создается впечатление о почти

полной функциональной идентичности (табл. 1).

В чем же отличие и есть ли оно? Кому и в каких случаях лучше

использовать тот или иной инструмент? Несмотря на то, что реальное

использование таких инструментов для решения поставленных задач требует

значительных финансовых вложений, попробуем их сравнить.

Санкт-Петербургский государственный университет – пока

единственная в России организация, в которой есть подписка на оба ресурса

и почти двухлетний опыт использования как «SciVal spotlight», так и

«InCites».

16

Таблица 1

Сопоставление инструментов «InCites» и «SciVal spotlight»

«InCites» позволяет узнать: «SciVal spotlight» позволяет узнать:

Сколько статей опубликовано

учреждением/страной?

Какие статьи самые влиятельные в какой

научной области?

Какие авторы являются «восходящими

звездами»?

Как я могу узнать h-индекс отдельных

исследователей или отдела?

Меняется ли направление исследований в моем

учреждении?

Как выглядит мое учреждение по сравнению с

конкурентами или желательными соратниками?

Каковы сильные стороны в моем учреждении?

Какие из них нуждаются в улучшении?

Какая средняя цитируемость в моем

учреждении или в отдельных областях?

Кто с кем сотрудничает? И как часто?

Насколько эффективны были ранее

принятые стратегические решения?

Как распределить наилучшим образом

ограниченные внутренние ресурсы?

Используем ли мы перспективные

направления наших сильных

исследований?

Как мы выглядим на фоне конкурентов

в наших областях исследований?

Каких исследователей стоило бы

пригласить к сотрудничеству?

Кто наши потенциальные партнеры?

Как нам следует разнообразить наше

исследовательское портфолио?

Необходимо ли нам отрегулировать

наш исследовательский фокус?

Как мы можем реализовать нашу

новую стратегию наилучшим

способом?

Что же можно узнать из анализа публикаций в «SciVal spotlight»? Самое

первое, что бросается в глаза – это «колесо науки», представленное так, что

длины дуг разного цвета соответствуют соотношению количества

публикаций в соответствующих областях науки в мире в анализируемый

промежуток времени. «Кружочки» внутри колеса соответствуют кластерам

публикаций, составляющих конкретную узкую предметную область,

«компетенцию». Эти кластеры составлены на основе анализа кросс-

цитирования. Если на одни и те же статьи ссылаются разные ученые, то эти

ученые работают в одной или близких областях. Путем такого анализа всех

имеющихся в базе данных Scopus публикаций Elsevier составляет кластеры —

выделено более 70 тысяч кластеров по узким научным направлениям. Если

статьи организации оказываются в числе наиболее цитируемых статей в

конкретном кластере публикаций, то считается, что в организации имеется

соответствующая компетенция. В зависимости от количества публикаций,

17

попадающих в разряд наиболее цитируемых, компетенции организации

определяются как явные (distinct) или зарождающиеся (emerging). Их-то мы и

видим как кружочки в колесе наук. Таким образом, кружочки представляют

собой статьи авторов организации в тех областях, где организация занимает

лидирующее положение в мировой науке. Диаметр соответствует количеству

публикаций, а положение – дисциплинарную область. Чем ближе к центру

колеса располагаются кружочки, тем более междисциплинарный характер

имеет соответствующий кластер публикаций [4]. Рассматривая

сформированные за за периоды 2005–2009 гг., 2006–2010 гг. и 2007-2011 гг.

диаграммы, представляющие «колесо наук» видно, что состав публикаций и

групп-лидеров СПбГУ изменяется (рис.3). Появляются новые компетенции,

несколько расширяется представление областей наук и уровень

междисциплинарности. Таким образом, данные «SciVal spotlight» за

последовательно взятые промежутки времени подтверждают наметившуюся

тенденцию к увеличению междисциплинарности исследований в СПбГУ.

Другой способ представления тех же данных – матричный – показывает

положение выделенных кластеров публикаций организации в мировой

(европейской, российской) системе научных публикаций (Рис. 4). Положение

кружочка по горизонтали показывает относительную долю статей

организации в мировом (европейском, российском) объеме публикаций по

соответствующей компетенции. По вертикали положение соответствует

скорости роста количества публикаций этой компетенции в мире (Европе,

России). Таким образом, если кластер публикаций расположен в правом

верхнем квадранте – то эта компетенция лидирует как по количеству

публикаций, так и по интересу к этой области. Если рассматривать такую

диаграмму с административной точки зрения, то нетрудно догадаться, что

вкладывать значительные финансовые средства в развитие научной области,

которая представлена в нижнем левом квадранте, даже если количество

публикаций в этой области велико, нерационально. Это все равно, что в

18

эпоху космических кораблей финансировать расчет на суперкомпьютере

полета воздушного шара.

19

Рис.3. Скриншоты данных «SciVal spotlight» для СПбГУ за 2009–2011 гг.

20

Рис.4. Матричное представление данных о публикациях СПбГУ в «SciVal spotlight»,

2008 и 2011 гг.

Для каждой представленной компетенции в «SciVal spotlight» доступна

информация по составу авторов публикаций в собственной организации,

организациях-конкурентах, сотрудничающих организациях. Имеется также

доступ к статьям в «Scopus».

Сравнение последовательных визуальных представлений показывает,

что развитие научных исследований в СПбГУ идет в мировом тренде.

Одной из наиболее интересных особенностей «SciVal Spotlight» является

возможность подробного анализа сложившихся научных связей по данным о

совместных публикациях. Эта возможность позволяет более объективно

оценивать необходимость развития сотрудничества с конкретными

научными организациями, определять перспективные для установления

связей научные направления, оценивать эффективность уже имеющихся

оформленных договоров о научно-техническом сотрудничестве.

А что показывает «InCites»? В первую очередь мы видим сводные

данные по всем публикациям и их цитированию, перечни самых пишущих,

самых цитируемых авторов и самых продуктивных научных направлений – в

виде диаграмм представлены динамика количества публикаций и их

цитирований, в виде списков – перечни авторов с указанием количества

опубликованных статей, цитирований, перечни по областям знаний с

указанием количества статей [5].

Легко можно сравнить публикационную активность в разных областях

знаний, причем данные уже рассчитаны с учетом разных уровней

цитирования в разных областях и нормированы к мировому уровню в

соответствующей научной области, поэтому сравнение естественных и

гуманитарных областей, например, представляется весьма корректным.

Очень удобен «InCites», когда надо сравнить показатели научной

активности разных организаций в целом и по отдельным областям знаний,

21

например, при выборе партнеров для сотрудничества. Большая база данных

по научным организациям разных стран позволяет это сделать с легкостью.

При решении вопроса о стратегическом сотрудничестве с какими-либо

организациями важно, чтобы это сотрудничество было взаимовыгодно. При

помощи сравнения публикационной активности и цитирования, визуального

представления их расчетных относительных показателей можно определить,

чем нам интересны конкретные организации и чем мы их можем

заинтересовать со своей стороны.

Сравнение, например, общих показателей цитируемости СПбГУ и

большинства зарубежных университетов, оказывается, как правило, не в

нашу пользу (рис. 5). Однако когда мы смотрим аналогичные показатели по

областям знаний, рассчитанные уже с учетом среднемировых уровней

цитируемости в конкретных научных направлениях, картина совсем другая.

Если нам, например, выгодно сотрудничество с университетами Израиля в

области биохимии, то мы им можем быть интересны в области экологии и

окружающей среды (рис. 6).

Рис.5. Сравнение показателей цитирования статей СПбГУ и израильских университетов

по отношению к среднемировому уровню

22

A

B

Рис.6. Сравнение относительных показателей цитирования статей СПбГУ и израильских

университетов в области экологии (А), биологии и биохимии (В)

Одной из самых интересных на сегодняшний день особенностей InCites

является возможность проанализировать, как будут изменяться

наукометрические показатели при составлении научной группы из разных

ученых, работающих в сходной области.

Одним из самых продуктивных авторов СПбГУ является специалист в

области математической физики А.В. Цыганов, что можно определить, в

частности, в «SciVal Spotlight» (табл. 2).

23

Таблица 2

Представление в «InCites» сводной информации о публикациях

А.В. Цыганова за 2002–2013 гг.

Р

а

н

г

Предметная

область

Число

цитиро

ваний

Число

документ

ов в WoS

Среднее

цитирование

для 1

документа

Реальное /

ожидаемое

цитирование

для журнала

Реальное /

ожидаемое

цитирование

для области

знания

Средний

перцент

иль

1 Математическая

физика

192 44 4,36 1,10 0,57 51,11

2 Физика,

междисциплинарн

ые аспекты

120 23 5,22 0,93 0,51 47,87

3 Прикладная

математика

61 15 4,07 1,85 0,82 43,62

4 Механика 59 14 4,21 1,90 0,81 45,23

5 Математика 7 4 1,75 2,26 0,47 68,06

6 Физика

элементарных

частиц

0 2 0,00 0,00 0,00 100,00

6 Ядерная физика 0 2 0,00 0,00 0,00 100,00

Если мы проанализируем показатели публикаций с добавлением

сторонних для СПбГУ авторов, работающих в сходной области, то увидим

значительное улучшение показателей цитирования в ядерной физике,

которая были далеко не основным направлением (табл. 3).

Таблица 3

Представление в «InCites» сводной информации о публикациях группы

авторов (А.В. Цыганов, С.С. Афонин, Дж. Негро) за 2002–2013 гг.

Р

а

н

г

Предметная

область

Число

цитиро

ваний

Число

документ

ов в WoS

Среднее

цитирование

для 1

документа

Реальное /

ожидаемое

цитирование

для журнала

Реальное /

ожидаемое

цитирование

для области

знания

Средний

перцент

иль

1 Математическая

физика 218 47 4,64 1,14 0,58 51,00

2 Физика,

междисциплинарн

ые аспекты

150 25 6,00 0,92 0,57 46,37

3 Физика

элементарных

частиц и полей

108 17 6,35 1,40 0,70 53,13

4 Ядерная физика 88 15 5,87 1,25 0,67 50,54

5 Прикладная

математика

61 15 4,07 1,85 0,82 43,62

6 Механика 59 14 4,21 1,90 0,81 45,23

24

7 Математика 7 4 1,75 2,26 0,47 68,06

8 Физика жидкости

и плазмы

00 1 0,00

8 Прикладная

физика 0 1 0,00

8 Атомная,

молекулярная,

химическая

физика

0 1 0,00

Наиболее наглядно это проявляется при сравнении визуальных

представлений тех же самых данных, являющихся характерной и узнаваемой

особенностью «InCites». Диаграммы показывают долю процитированных

статей. Рисунки отображают положение статей по отношению к средним

показателям: по журналам, в которых они опубликованы, по области знаний.

В них также содержится информация, отображающая, в какой процент самых

цитируемых работ попадают работы авторов. Характерной особенностью

InCites является наглядное визуальное представление всех метрик,

облегчающее их понимание [5].

На экране пользователь видит как численные данные по количеству

опубликованных статей, их цитированию первого и второго поколения,

индекс Хирша, среднее цитирование и др., так и диаграммы, показывающие

наглядно показатели конкретного автора (группы авторов, организации) по

сравнению со среднемировыми показателями. На диаграммах показаны

отношение количества статей, процитированных хотя бы один раз, к общему

количеству статей авторов в «Web of science»; среднее значение уровня

цитирования статей по сравнению с мировым уровнем. На графике показано,

на какую долю отличается количество статей, попавших в 1%, 5%, 10% и т.д.

самых цитируемых статей, по сравнению со среднемировым уровнем.

«Category actual/expected cites» показывает среднее значение отношения

реального цитирования статей к ожидаемому цитированию, рассчитанному

по каждой области знаний, по каждому году и типу публикаций отдельно.

«Journal actual/expected cites» показывает среднее значение отношения

реального цитирования статей в конкретных журналах к ожидаемому

цитированию статей в этих журналах.

25

Такой анализ может оказаться крайне полезным при приглашении на

работу в университет специалистов из других организаций, при подготовке

заявок на гранты (например, при формировании заявок на Гранты

Правительства для приглашения ведущих ученых в вузы по Постановлению

220).

Новой особенностью «InCites», появившейся летом 2011 г., является

возможность ознакомления со сводной информацией об организации,

которая формируется в процессе составления рейтинга университетов «Times

higher education», методологию которого с 2009 г. разрабатывает компания

«Thomson Reuters». Эта опция дает возможность сравнивать не только

наукометрические показателей университетов, но и другие, важные для

развития вузов параметры – уровень образовательной деятельности,

интернационализацию, финансирование, мнения академического сообщества

и др.

В целом можно отметить следующие достоинства и недостатки

использования описанных современных инструментов наукометрии (табл. 4).

Таблица 4

Достоинства и недостатки современных инструментов наукометрии

Плюсы Минусы

Отсутствие трудоемких расчетов

Возможность легкого сопоставлений разных

научных областей

Возможность сравнения своей организации или

страны с другими

Возможность оценивать продуктивность научного

сотрудничества

Удобство использования для стратегического

планирования

Основано, в основном, на зарубежных публикациях,

практически не учтены российские журналы

Нельзя опираться только на данные библиометрии

без учета других результатов научной деятельности,

например, патентов

Итак, оба рассмотренных инструмента очень полезны для планирования

и анализа научной деятельности как в организации, так и на уровне города

или страны. Выбор аналитического инструмента зависит от поставленной

цели. Для стратегического планирования развития научной деятельности в

организации и выбора направлений финансирования удобнее использовать

26

«SciVal spotlight». Для сравнения с другими конкретными организациями или

отслеживания активности отдельных ученых, групп ученых или направлений

наук предпочтительнее выбрать «InCites». Для всестороннего развития в

сотрудничестве с мировым академическим сообществом оптимально

использование комплекса аналитических инструментов.

Таким образом, использование методов наукометрии (библиометрии)

является весьма полезным и удобным инструментом для планирования и

оценки научной деятельности как в области стратегии организации научных

исследований, так и в отношении текущего ее осуществления. Однако

имеющиеся объективные недостатки не позволяют использовать только

наукометрические показатели для оценки деятельности научного учреждения

или вуза и принятия каких-либо административных решений на основании

этих показателей.

В целом из всего вышесказанного можно сделать следующие выводы:

1. Использование наукометрических данных для сравнения научной

продуктивности и эффективности научной деятельности вполне оправдано,

но не может являться единственным критерием, на основе которых

принимаются административные решения.

2. Для внедрения наукометрических способов оценки научной

деятельности необходимо централизованное решение об обеспечении

доступа вузов к платным наукометрическим ресурсам или использование

исключительно свободных источников. В случае с РИНЦ это может

оказаться вполне возможным, однако требуются значительные затраты на

доработку и наполнение этого ресурса.

Литература

1. Карпенко О.М., Бершадская М.Д., Вознесенская Ю.А. Международные рейтинги

университетов: Результаты и перспективы // Социология образования. – М., 2007. – №

12. С. 49–63.

27

2. Конкурсная документация по проведению открытого конкурса на право заключения

государственных контрактов на выполнение поисковых научно-исследовательских

работ для государственных нужд в рамках федеральной целевой программы «Научные

и научно-педагогические кадры инновационной России» на 2009-2013 годы

(мероприятия 1.2.1 – 1.2.2). – Режим доступа:

http://zakupki.gov.ru/pgz/public/action/orders/info/common_info/show?notificationId=1250

360

3. Методические указания по заполнению Приложения 3 к конкурсной документации на

проведение открытого публичного конкурса на получение грантов Правительства

Российской Федерации для государственной поддержки научных исследований,

проводимых под руководством ведущих ученых в российских образовательных

учреждениях высшего профессионального образования. – Режим доступа:

http://www.p220.ru/contest/2010/contest_doc/

4. Москалева О.В. SciVal для планирования научной деятельности в вузе. Материалы

научно-практической конференции «Региональное лидерство в науке и

инновациях» – Томск, 2012. – 26 апр. – Режим доступа:

http://elsevierscience.ru/events/tomsk2012/schedule/

5. Москалева О.В. Опыт использования инструмента InCites в СпбГУ. Материалы XVI

международной конференции «SCIENCE ONLINE: электронные информационные

ресурсы для науки и образования», 19 — 26 мая 2012 г. г. Ла-Пинеда, Испания. Режим

доступа: http://elibrary.ru/projects/conference/spain2012/presentations/incites1.pdf

6. Писляков В.В. Библиометрия: Основные методы и индикаторы. Материалы научно-

практического семинара «Оценка результативности научно-исследовательской

деятельности». – Казань, 2011. – 20 окт. – Режим доступа:

http://elsevierscience.ru/events/kazan2011/schedule/

7. Приказ Министерства образования и науки от 29 июля 2009 года №276 «О перечне

показателей, критериях и периодичности оценки эффективности реализации программ

развития университетов, в отношении которых установлена категория «национальный

исследовательский университет»». – http://old.mon.gov.ru/files/materials/5561/276.pdf

8. Приказ Рособразования от 28 ноября 2008 г. № 1770. – Режим доступа:

http://www.edu.ru/db/mo/Data/d_08/a1770.html

9. ARWU. Ranking methodology. – Mode of access:

http://www.arwu.org/ARWUMethodology2010.jsp

28

10. Falagas M.E., Kouranos V.D., Arencibia-Jorge R., Karageorgopoulos D.E. Comparison of

SCImago journal rank indicator with journal impact factor // The journal of the Federation of

American societies for experimental biology. – 2008. – Vol. 22. – P. 2623–2628.

11. Hirsch J.E. An index to quantify an individual’s scientific research output // Proceeding for

National academy of science. – Wash., 2005. – Vol. 102, N 46. – P. 16569–16572.

12. Moed H.F. Measuring contextual citation impact of scientific journals. – 2009 — Mode of

access: http://arxiv.org/abs/0911.2632

13. Pratt S. World university rankings subject tables: Robust, transparent and sophisticated. –

2010. – Mode of access: http://www.timeshighereducation.co.uk/world-universityrankings/2010-2011/analysis-methodology.html

14. QS World University Rankings methodology. — Mode of access:

http://www.iu.qs.com/university-rankings/world-university-rankings/

15. SCImago journal & country rank. – Mode of access: http://www.scimagojr.com

Москалева Ольга Васильевна, Использование наукометрических

показателей для оценки научной деятельности, Санкт-Петербургский

государственный университет, г. Санкт-Петербург

Moskaleva Olga V., Using of scientometric indices for research assessment, Saint

Petersburg state university, Saint Petersburg, olga@science.pu.ru

Оригинал статьи — Using of scientometric indices for research assessment Moskaleva2013.pdf